ReCo – Textantworten aus Assessments automatisch verarbeiten

Projekte des ReCo-Teams drehen sich stets um Textantworten. So bewertet die Software ReCo etwa automatisch, ob eine Antwort im PISA-Test richtig ist. Das Team stellt eine Reihe von Apps bereit, die sich rund um automatisches und halb-automatisches Kodieren von Antworten bis hin zum Einsatz ohne Bewertungen im Unterricht drehen.

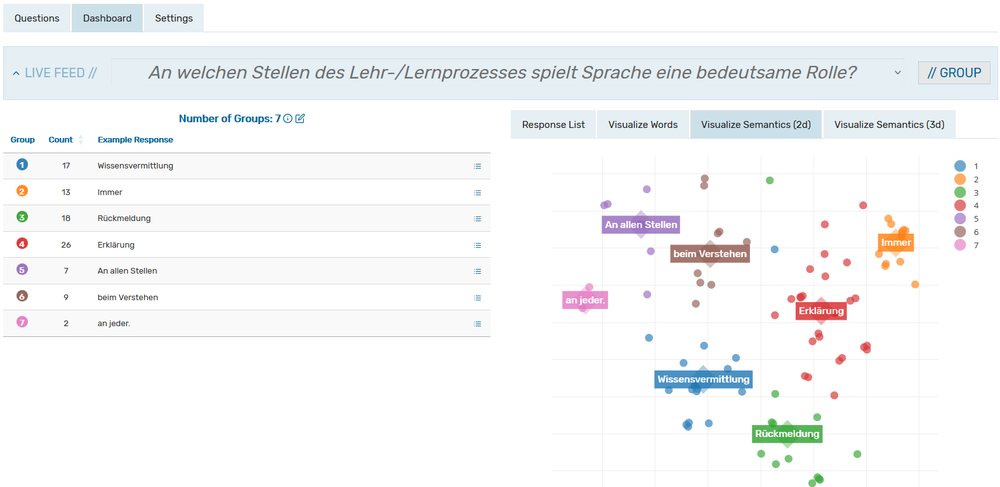

Das ReCo-Team (Automatic Text Response Coding) bearbeitet eine Vielzahl an Projekten für das TBA-Zentrum am DIPF. Sie alle drehen sich um das automatische Auswerten von Textantworten. Sowohl in der Forschung als auch Entwicklung kommen dabei moderne Technologien zum Einsatz, die häufig mit Methoden der künstlichen Intelligenz assoziiert werden: natürliche Sprachverarbeitung, Large Language Models und maschinelles Lernen. Die entsprechenden Transferprodukte sollen entweder die Arbeit von Forschenden oder Personen aus der Bildungspraxis unterstützen. Gleich mehrere Projekte bieten daher frei verfügbare, interaktive Apps an. Mit diesen können etwa Forschende ihre Textdaten aus Assessments automatisch bewerten (Software ReCo) und Lehrkräfte können im Unterricht Fragen von allen Lernenden live sammeln und auf einem Dashboard automatisch gruppieren lassen (s. Abbildung).

Bereits seit 2015 wurde die Methodik hinter der Software ReCo an der Technischen Universität München und im Zentrum für Internationale Bildungsvergleichsstudien (ZIB) e.V. entwickelt, implementiert sowie beforscht und wird inzwischen unter derselben Projektleitung am TBA-Zentrum stetig modernisiert. Da Large-Scale Assessments wie PISA zu den wichtigsten Anwendungsfeldern für die automatische Kodierung gehören, stellt die fortgesetzte Kooperation mit dem deutschen PISA-Zentrum an der TU München bzw. des ZIB eine wichtige Komponente für die Projekte dar.

Leistungsmessung in der Bildungsforschung verbessern

Bei der Konstruktion von Leistungstests stehen Forschungsgruppen zumeist vor der Frage, welches Antwortformat angemessen ist. Werden Antwortmöglichkeiten vorgegeben, wie etwa im Multiple-Choice-Format, können die Antworten leicht verarbeitet werden. Dieses geschlossene Format bringt aber neben Rateeffekten weitere unerwünschte Nebeneffekte mit sich. Dürfen die Befragten hingegen offen in ein Textfeld schreiben, was sie für die richtige Antwort halten, ist die Auswertung in vielen Fällen kompliziert. Ein Vorteil aber ist, dass dadurch ein tieferes Verständnis gemessen werden kann, als es in einigen Domänen durch ein geschlossenes Format möglich ist, da die Befragten dabei eine Antwort produzieren und nicht nur die richtige erkennen müssen.

Daher hat sich die OECD bereits in der PISA-Studie 2000 dafür entschieden, auch einige Aufgaben mit offenem Format zu verwenden. Der resultierende Aufwand für die Auswertung ist speziell bei einer so großen Studie wie PISA enorm. In allen teilnehmenden Staaten und Regionen müssen Teams aufwändig geschult werden, um die vielen Antworten der inzwischen insgesamt mehr als 500.000 Schüler*innen zu bewerten. Dabei erhalten sie Richtlinien, um die Bewertungen möglichst objektiv und vor allem über Sprachen hinweg vergleichbar vorzunehmen.

Da Menschen aber immer auch ihre subjektiven und kulturellen Perspektiven mitbringen, besteht das Risiko inkonsistenter Beurteilungen. Hinzu kommt, dass Menschen bei einer so großen Menge an Antworten auch Fehler aufgrund mangelnder Ausdauer unterlaufen können. Wird hingegen eine Computersoftware zur automatischen Auswertung der Textantworten hinzugezogen, wird die Auswertung sowohl innerhalb als auch zwischen Teilnehmerstaaten konsistenter und damit objektiver. Auch die hohe Anzahl der Antworten stellt dann keine Hürde mehr dar. Diese automatische Auswertung der Textantworten kann inzwischen für einige Datensätze zufriedenstellend geleistet werden.

Geförderte internationale Forschungsprojekte: Automatische Bewertung in PISA und deren Zusammenhänge mit sprachlicher Varianz in ePIRLS

Gleich zweifach konnte das ReCo-Team jüngst Förderung für Forschungsprojekt einwerben, die direkt auf den operativen Einsatz automatischer Auswertung von Textantworten in großen, internationalen Large-Scale Assessments zielten. Im von der OECD geförderten Forschungsprojekt zur Entwicklung und Innovierung von PISA ging es um die Weiterentwicklung des bisher eingesetzten sogenannten Machine-Supported Coding Systems. Dieses ermöglichte, bestimmte Antworten, die bereits zuvor mehrfach vom Menschen bewertet wurden, automatisch zu bewerten. Dafür wurden schlicht exakt übereinstimmende Antworten herangezogen. Während dies bereits zu einer deutlichen Verringerung manuellen Aufwands führte, war die Einsetzbarkeit jedoch stark eingeschränkt, weil Textantworten bei vielen Aufgaben neben der Argumentation ebenso stark in der Schreibweise und Formulierung variieren. In einer Kooperation mit ETS, USA und der Sogang University, Südkorea, konnte die Methodik federführend vom ReCo-Team weiterentwickelt werden, die nun Fuzzy Lexical Matching (FLM) genannt wird. Dabei werden sukzessiv mehr Abweichungen von der exakten Übereinstimmung zwischen Antworten erlaubt, deren Anwendung aufgaben- sowie sprachspezifisch optimiert wird. Dies führt zu großen Einsparungen in der menschlichen Kodierung ohne Verlust der Genauigkeit, wie über eine große Vielfalt von Sprachen gezeigt werden konnte (von u.a. Arabisch über Hebräisch, Koreanisch und Kasachisch hin zu Englisch). Dies spart finanzielle und zeitliche Ressourcen ein und verbessert die Datenqualität durch höhere Konsistenz substanziell. Die OECD plant, diese automatische Unterstützung operativ einzusetzen.

Das zweite genannte Forschungsprojekt wurde von der IEA gefördert, um zwei Forschungsfragen rund um dessen Pendant zur Lesekompetenzmessung ePIRLS nachzugehen. Erstens wurde auch hier die Genauigkeit der automatischen Auswertung mithilfe des Fuzzy Lexical Matching (FLM), aber auch moderner semantischer Repräsentationen mittels Large Language Models evaluiert. Zweitens war der Zweck deren Anwendung allerdings primär, zu untersuchen, welche Charakteristika der Aufgaben sowie Testpersonen mit der maschinellen Bewertungsgenauigkeit zusammenhängen. Wie zuvor angenommen, konnte gezeigt werden, dass die sprachliche Vielfalt in Antworten für Schwierigkeiten bei der automatischen Kodierung sorgte. Als weiterer zentraler Hauptbefund konnte außerdem festgestellt werden, dass die Genauigkeit großteils unabhängig von der jeweiligen Sprache funktionierte, was vielversprechend für den Einsatz in mehrsprachigen Kontexten ist (weitere Details im Projektbericht). Dieses Projekt wurde unter Federführung der Sogang University, Südkorea sowie in Zusammenarbeit mit der FernUniversität Hagen durchgeführt.

ReCo-Live lässt alle Lernenden im Unterricht partizipieren

Im Unterricht stellen Lehrende regelmäßig Fragen an die Lernenden. Häufig melden sich dann vereinzelte Lernende und eine oder einer von ihnen formuliert eine Antwort auf die Frage. Das kann für einzelne Zwecke im Klassendiskurs effektiv sein. Wenn aber alle Lernenden mobilisiert werden sollten, verfehlt dieses Format seinen Zweck. Stattdessen erlaubt es die App ReCo-Live, die Antworten aller Lernenden live im Unterricht zu sammeln, indem diese ihre Antworten in mobile Endgeräte eingeben. Somit partiziperen alle Lernenden und der Unterrichtsdiskurs ist potenziell inklusiver. Alle Antworten werden dann auf dem Dashboard der Lehrkraft angezeigt und auf Wunsch anhand ihrer Ähnlichkeit in Bezug auf ihre Bedeutung in nur wenige Antworttypen gruppiert (s. Abbildung oben). Auf diese Weise sieht die Lehrkraft typische Antworten sowie herausstechend Misskonzepte oder auch treffliche gelungene Antworten, anhand derer sie den Unterrichtsdiskurs fortführen kann.

Das Projekt wird in Zusammenarbeit mit dem Arbeitsbereich SchuLe am DIPF sowie dem Programm LernMINT der Leibniz Universität Hannover durchgeführt.

Die Projekte drehen sich um das automatische Auswerten offener Textantworten, häufig aus Assessments oder aber dem Unterricht. Die Forschungsprojekte zielen darauf ab, durch methodische Weiterentwicklungen und relevante Befunde die Forschung voranzubringen, während die Transfer- und Infrastrukturprojekte den direkten Transfer in die Forschungs- und Bildungspraxis anhand einer frei verfügbaren Software verfolgen.

Das Projekt wird über DIPF-Haushaltsmittel und Drittmittel finanziert.

Dieses Projekt erfolgt in Zusammenarbeit mit...

- Technische Universität München

- Zentrum für Internationale Bildungsvergleichsstudien (ZIB) e.V.

- International Association for the Evaluation of Educational Achievement (IEA)

- Organisation for Economic, Co-operation and Development (OECD)

- Educational Testing Service (ETS)

- Leibniz Universität Hannover

- FernUniversität Hagen

Status: Laufendes ProjektSchwerpunkt: Bildung in der digitalen Welt Abteilung: Lehr- und Lernqualität in Bildungseinrichtungen Arbeitsbereich: Technology-Based Assessment Bildungsbereiche: Hochschule, Schule, Wissenschaft Laufzeit: 04/2017 - 12/2027Finanzierung: DIPFKontakt: Dr. Fabian Zehner, Habilitand